Projetos em andamento

|

Abordagens mult-ômicas para estudo de comunidades microbianas para descoberta de novas estratégias de desconstrução de biomassa lignocelulósica (lnbr_bag19) Centro Nacional de Pesquisa em Energia e Materiais Laboratório Nacional de Biorrenováveis Coordenador: Gabriela Felix Persinot Áreas do conhecimento: Biodiversidade; Ciências biológicas Início da vigência: 15-10-2019 A biomassa lignocelulósica é a principal fonte de carboidratos renováveis do mundo e é considerada uma plataforma sustentável para a produção de bioprodutos como biocombustíveis, blocos químicos de base biológica e biopolímeros. Um dos principais desafios da bioconversão de biomassa lignocelulósica em bioprodutos é a transformação dos polissacarídeos presentes na biomassa em açúcares fermentescíveis. Comunidades microbianas presente em ambientes naturais como solos recoberto por biomassa e intestino de aninais herbívoros como ruminantes, possuem naturalmente grande capacidade de obter energia a partir de biomassa lignocelulósica. Essa capacidade encontra-se codificada no potencial genético dos micro-organismos presentes nestes ambientes, porém, muitas vezes esse potencial é pouco ou apenas superficialmente explorado. O recente desenvolvimento das tecnologias de sequenciamento de ácidos nucleicos, impulsionaram o uso de abordagens em larga escala independentes de cultivo, como a metagenômica, a qual se tornou uma poderosa ferramenta que permite acessar o potencial genético de comunidade microbianas por meio do sequenciamento direto do DNA ambiental. Neste sentido, a metagenômica é uma técnica promissora para prospecção de enzimas degradadoras de biomassa vegetal, pois além de permitir estudos de diversidade microbiana, permite acessar o genoma desses organismos incultiváveis possibilitando a descoberta de genes envolvidos em variadas atividades enzimáticas de sistemas biológicos até então desconhecidos. Estas técnicas apenas fazem sentido se suportados pela área de pesquisa de Bioinformática e computação de alto desempenho, as quais visam atribuir significado biológico ao enorme volume de dados gerado. Nesse sentido, este projeto visa o desenvolvimento e aplicação de abordagens in silico de Bioinformática para explorar o potencial genético de comunidades microbianas de forma a aprofundar o conhecimento acerca da diversidade de micro-organismos e enzimas presentes em ambientes naturais, visando compreender as estratégias naturalmente empregadas pelas comunidades microbianas para desconstrução de materiais lignocelulósicos e explorar de forma racional o potencial existente para a prospecção de novas enzimas ou microrganismos. Por meio de análises integradas multi-ômicas de comunidades microbianas recuperada de solo recoberto com bagaço de cana-de-açúcar e de intestino de herbívoros, espera-se com esse projeto poder contribuir com a elucidação da diversidade filogenética dessas comunidades e com isso possibilitar a descoberta de genes, enzimas, genomas e microrganismos envolvidos na degradação de materiais lignocelulósicos, que podem ser de grande interesse para aplicações biotecnológicas. |

|

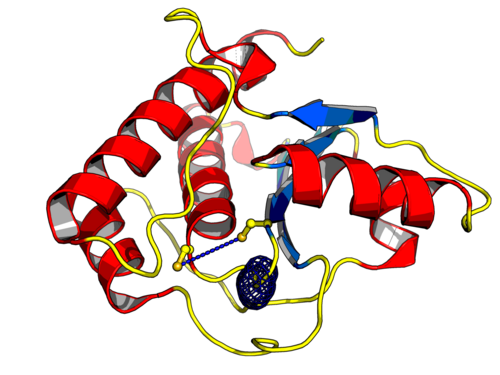

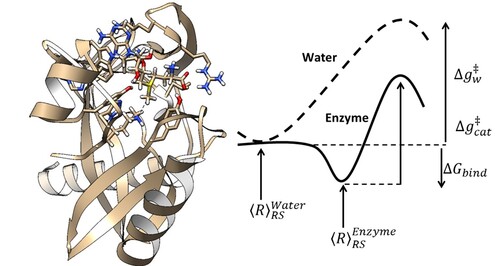

Análise Computacional de proteínas consideradas alvos moleculares para o tratamento da esquistossomíase e leishmanioses (nddrug) Universidade Federal de Juiz de Fora Departamento de Ciência da Computação Coordenador: Priscila Vanessa Zabala Capriles Goliatt Áreas do conhecimento: Ciência da computação; Ciências biológicas; Ciências da saúde; Farmácia; Química Início da vigência: 10-07-2017 Doenças parasitárias são um dos principais problemas de Saúde Pública, porém são consideradas como doenças negligenciadas por serem endêmicas em populações de baixa renda e por apresentarem investimentos reduzidos em produção de medicamentos. Como exemplo, pode-se citar a esquistossomíase (ou esquistossomose) e as leishmanioses. A esquistossomíase é uma doença aguda ou crônica que acomete principalmente o intestino. É causada por vermes do gênero Schistosoma, destacando-se o S. mansoni, e afeta cerca de 239 milhões de pessoas no mundo, com cerca de 6 milhões de pessoas infectadas somente no Brasil. As leishmanioses, causadas por protozoários do gênero Leishmania, possuem manifestações desde lesões cutâneas até injúrias severas das vísceras, podendo levar a óbito. O CDC (do inglês, Centers for Disease Control and Prevention) considera as leishmanioses como a segunda maior causa de morte no mundo por doenças parasitárias, sendo reportados cerca de 2 milhões de novos casos/ano. As drogas usuais possuem baixa eficácia e diversos efeitos colaterais devido esses parasitas apresentarem enzimas com funções semelhantes às encontradas em seres humanos. Adicionalmente, é crescente o número de eventos de resistência a essas drogas. Portanto, a busca por enzimas ditas potencias alvos moleculares é fundamental para o desenvolvimento de drogas mais eficazes e com menos efeitos colaterais, promovendo maior adesão dos pacientes ao tratamento completo dessas doenças. Os altos custos dos estudos experimentais têm elevado o uso de ferramentas de Biologia Computacional para entender a estrutura de alvos moleculares e os mecanismos de interação entre essas proteínas e seus possíveis inibidores. O modo de interação entre essas proteínas em S. mansoni e Leishmania sp. e compostos com potencial inibitório ainda é desconhecido. Em estudos anteriores, realizamos a modelagem tridimensional da NTPDase1 de S. mansoni (SmNTPDase1), enzima considerada alvo molecular para o tratamento da esquistossomíase, e seu homólogo em humanos (HsNTPDase1 ou CD39). Através da análise comparativa entre a SmNTPDase1 e a NTPDase1, por dinâmica molecular (DM) e docking com compostos candidatos a inibidores da SmNTPDase1, verificamos que mudanças conformacionais importantes nessas proteínas levam a diferentes afinidades de interação com os inibidores. Através deste projeto, poderemos elucidar esses modos de interação, de modo a auxiliar na remodelagem desses compostos ou no desenho racional de novos fármacos mais eficazes e com menos efeitos colaterais. Atualmente, alvos em L. braziliensis e L. amazonensis estão sendo mapeados. Alvos como a tripanotiona reductase já foram modelados, estão sendo testados contra compostos candidatos à leishmanicida e deverão seguir para análises por DM. Em computadores com arquitetura multicore, as análises por DM de cada alvo podem custar até um ano de simulação. Para a análise comparativa dessas enzimas e seus homólogos humanos esse custo pode inviabilizar um projeto com financiamento de até 24 meses. Portanto, é necessário o uso de supercomputadores com GPU, sendo o SDumont um componente essencial neste projeto. Acreditamos que este projeto possa impactar na validação de compostos em estudo como antiparasitários, culminando na elaboração de patentes. Acreditamos também, que nossa pesquisa tem impacto científico relevante, cujos resultados podem representar contribuições biotecnológicas diretas em setores produtivos da sociedade. |

|

Análise de mutações correlacionadas por Dinâmica Molecular em fosfatases de baixo peso Molecular (lmwptpdm) Universidade Federal de Minas Gerais Instituto de Ciências Biológicas Coordenador: Lucas Bleicher Áreas do conhecimento: Ciências biológicas Início da vigência: 27-07-2016 Um dos eventos celulares de mediação química mais importantes e úbiquos nos organismos vivos é a fosforilação, cuja dinâmica ocorre devido a existência de múltiplas enzimas responsáveis por catalisar a adição (quinases) e remoção (fosfatases) de grupos fosfato em outras moléculas. Em organismos multicelulares, a fosforilação/desfosforilação de Tirosina em proteínas é especialmente importante para diversas vias de sinalização celular. Dentre os diversos ramos da ciência mundial, a Bioinformática é tida como uma área de desenvolvimento recente e de grande interdisciplinariedade, sendo imprecindível ao tratamento adequado das grandes quantias de dados biológicos obtidas pelas técnicas de Biologia Molecular atuais, assim sendo capaz de resolver inúmeros problemas de natureza biológica. Nesse estudo, utilizamos inicialmente técnicas estatísticas para a extração de possíveis correlações e anticorrelações entre amino ácidos de um alinhamento correspondente a uma família ubíqua e ancestral de tirosino-fosfatases: As Fosfatases de Baixo Peso Molecular (do inglês LMW-PTPs). Esta família de proteínas, agrupa enzimas de um padrão único de enovelamento, mas que diferem em um um grupo capaz de desfosforilar tirosina e outro cujas enzimas são responsáveis pela redução de Arsenato em Arsenito. As LMW-PTPs humanas são relacionadas a múltiplas doenças, das quais destacam-se inclusive alguns tipos de câncer. Ainda não se entende completamente quais os mecanismos moleculares que implicam em diferenças na especificidade e na atividade das proteínas desta família. Inicialmente buscamos relacionar funções biológicas a grupos de resíduos correlacionadas através de uma revisão bibliográfica e de análises em estruturas cristalográficas desta família. Estas evidenciaram o papel de vários resíduos de nossa análise, embora as funções biológicas relacionadas a algumas de nossas correlações sejam bastante elusivas. Existe portanto interesse científico na descrição dos mecanismos moleculares de especificidade, nos processos alostéricos dessas enzimas, e no desenvolvimento de possíveis inibidores as mesmas. O estudo aqui proposto destas enzimas, e do papel dos resíduos que encontramos neste trabalho por técnicas de Dinâmica Molecular será então capaz de promover um avanço no entendimento dessa família de proteínas, podendo servir como base a futuros ensaios experimentais, além de ser capaz de divulgar e gerar conhecimento científico em uma área de ponta. |

|

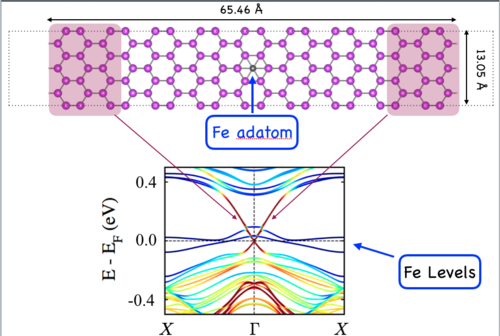

Atomistic Simulations of Material’s interfaces for solar energy devices (asmsol) Universidade Estadual Paulista Júlio de Mesquita Filho Instituto de Física Teórica Coordenador: Alexandre Reilly Rocha Áreas do conhecimento: Química Início da vigência: 28-09-2016 This project aims to provide accurate predictions at atomic and molecular level of the interfaces of solar energy devices, which would be used for experimentalist in the seeking of new materials for designing novel solar energy devices. Our research proposal involves state of art simulations, which play a key role in predicting physical and chemical properties at atomistic scale, for studying the charge-transfer (CT) processes occurring at the interfaces of OPCs. Special attention will be given in seeking different blend of donor/acceptor materials based: on graphene nanoribbons and organic semiconductors. In particular, we will tailor the energy levels of GNRs by functionalization and doping, in order to explore its role over the CT states to obtain heterojunctions with improved properties. To this aim, the methodology will be based on the many-body perturbation theory, which have been successfully used in describing excited states of several molecular systems. Thus, within the so-called GW approximation, we will be able to correct the Kohn-Sham (DFT) energy levels at the interfaces of the blend of donor/acceptor. Furthermore, by using these corrected energies and by solving the Bethe-Salpeter equation (BSE), we will be able to simulate accurately the optical properties, energy-loss spectra and the charge-transfer process at the interfaces of OPCs as well as their implications for designing more efficient devices. We also want to understand the electrodes, which are used to harvest the electrons and holes generated by light adsorption. In this case we need to understand the transport properties of this materials, which typically contain impurities. Understanding the effects of these impurities is tantamount for the design of good electrodes. |

|

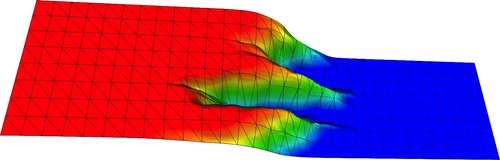

Balanceador de carga distribuído MPI para métodos geofísicos com grandes instâncias de dados (ctws-fwi) Universidade Federal do Rio Grande do Norte Departamento de Engenharia de Computação e Automação Coordenador: Samuel Xavier de Souza Áreas do conhecimento: Ciência da computação; Engenharias; Geociências Início da vigência: 07-06-2019 O balanceamento centralizado de grandes cargas de trabalho pode fazer com que o escalonamento se torne um gargalo de desempenho e eficiência. Cada vez maiores em tamanho, levantamentos sísmicos 3D requerem uma logística de dados cada vez mais complexa para distribuir dados de tiros para os nós de computação em ambientes HPC. A fim de manter o tempo dos resultados dentro dos limites desejáveis, muitas vezes a decomposição do domínio dentro de um único tiro também é aplicada, tornando a pressão sobre um escalonador centralizado ainda maior. Este projeto tem como objetivo desenvolver um escalonador descentralizado para balancear grandes cargas de processamento em grandes infraestruturas de HPC. Serão empregadas técnicas como o "work stealing" que já foram aplicadas com sucesso para equilibrar a carga de trabalho do Cilk Plus, um modelo de programação de memória compartilhada desenvolvido no MIT e que agora pertence à Intel Software. A responsabilidade do balanceamento de carga deve ser distribuída entre os nós computacionais sem uma autoridade de escalonamento centralizada para evitar agravar gargalos computacionais. Ao longo da evolução da computação, tarefas podem ser trocadas entre nós para evitar que processadores fiquem ociosos. Embora a técnica proposta possa ser aplicada a diversos métodos computacionais, nossas aplicações iniciais serão a Migração Reversa no Tempo (RTM, do inglês Reverse Time Migration) e a Inversão Completa da Forma de Onda (FWI, do inglês Full Waveform Inversion). |

|

Brazilian Earth System Model: seasonal to centenial climate prediction (BESM-S2C) Instituto Nacional de Pesquisas Espaciais Centro de Previsão do Tempo e Estudos Climáticos Coordenador: Paulo Nobre Áreas do conhecimento: Ciência da computação; Ciências biológicas; Matemática; Meteorologia; Oceanografia; Probabilidade e estatística; Química Início da vigência: 07-03-2017

|

|

Buscando o mínimo global dos métodos quânticos semiempíricos NDDO (rm2) Universidade Federal de Pernambuco Departamento de Química Fundamental Coordenador: Alfredo Mayall Simas Áreas do conhecimento: Química Início da vigência: 15-07-2016

|

|

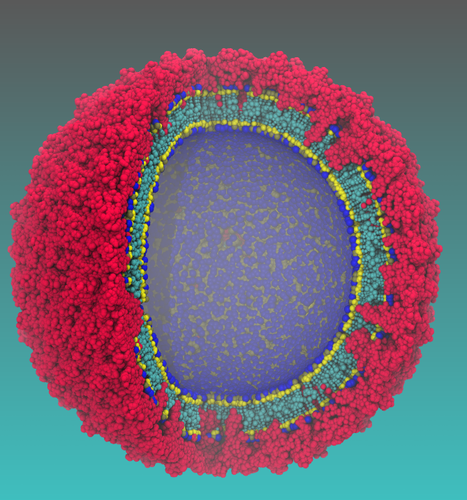

Caracterização in silico de alvos de medicamentos para Zika e Dengue (VICBF01) Universidade Federal de Pernambuco Departamento de Química Fundamental Coordenador: Gustavo de Miranda Seabra Áreas do conhecimento: Ciências biológicas; Química Início da vigência: 08-11-2016 Este é um trabalho sendo desenvolvido em colaboração com o prof. Sergio Pantano, do Group of Biomolecular Simulations, Institut Pasteur de Montevideo (Uruguay). A atual epidemia de Zika e outros flavivírus no Brasil e na América Latina aumentou em todo mundo a preocupação da saúde publica por causa das implicações médicas e sócio econômicas. Consequentemente, um grande esforço começou a ser dedicado para enfrentar esse problema. Nesses contexto, simulações de dinâmica molecular compõem uma importante alternativa para prover informações confiáveis para o Design racional de ferramentas terapêuticas. Além disso, instalações de supercomputadores permitem a triagem de um grande número de condições (i.e., mutações, concentrações, temperatura, pH, etc.) ajudando na aceleração, racionalização ou até mesmo evitando o consumo excessivo de tempo de trabalho experimental. Neste projeto nos propomos um colaboração internacional com foco em dois alvos de design de drogas: i) A proteína NS3 protease/helicase; e ii) a proteína de envelope. A proteína NS3 do vírus Zika possui grande identidade de sequencia com a mesma proteína em outros flavivirus, como o Dengue. Essa proteína possui dois domínios, protease e helicase, e é essencial no processo de replicação viral. Na realidade, alguns medicamentos antivirais já existentes no mercado, para HIV e Hepatite C, se baseiam na inibição da atividade desta proteína. Pretendemos utilizar o programa PMEMD, do pacote Amber16, para simular as etapas envolvidas na função da NS3 helicase, responsável pelo desenovelamento do RNA viral, para identificar sítios passíveis de ataque. Quanto ao domínio protease, pretendemos estudar a reação catalisada por esse domínio através de cálculos QM/MM, para identificar o mecanismo e as estruturas importantes, que podem também oferecer alvos para novos medicamentos. A segunda proteína é também um dos principais alvos, assim como a primeira no reconhecimento pela célula hospedeira. Recentemente, nós desenvolvemos e aplicamos um método de simulação Coarse Grained (Darré L, Machado MR, Brandner AF, Ferreira S, Gonzalez HC, Pantano S. SIRAH: a structurally unbiased coarse-grained force field for proteins with aqueous solvation and long-range electrostatics. JCTC, 2015, 11:723.) proposto de multi-escala para estudar a flexibilidade de estruturas recém-publicadas do envelope do Zika (Sirohi, D.; Chen, Z.; Sun, L.; Klose, T.; Pierson, T. C.; Rossmann, M. G.; Kuhn, R. J. Science The 3.8 A resolution cryo-EM structure of Zika virus: 2016, 352, 467-470). A introdução de mutações pontuais na estirpe Africana revela a estabilização estrutural do envelope do vírus (Machado et al, submetido ao JCTC), que acontece apenas a nível da estrutura quaternária. Nós usaremos a estrutura do vírus do Zika junto com a modelagem molecular e simulações multi-escala para gerar um conjunto completo de estruturas (aproximadamente 50 diferentes variantes com identidade ~90%, http://www.ianlogan.co.uk/zikapages/zika-current.htm). Isto proverá informações preciosas sobre a acessibilidade dos epítopes e sua estrutura, bem como a variabilidade dinâmica de diferentes variantes que circulam no Brasil. Nós planejamos gerar 1 microssegundo de simulações de dinâmica molecular de cada variante para gerar um imprescindível banco de dados que será disponibilizado para a comunidade cientifica por meio de websites com o objetivo de ajudar os biólogos computacionais que trabalham ao lado dos experimentalistas para antecipar o impacto de novas mutações. |

|

Derivação, otimização e implementação de parâmetros para boro, estanho e platina nos campos de força MMFF94S e AMBER, com potencial para o desenho de novas drogas (mmffdbsnpt) Universidade Federal Fluminense Instituto de Química Coordenador: Luciano Tavares da Costa Áreas do conhecimento: Ciências biológicas; Química Início da vigência: 12-07-2018 Compostos químicos contendo Pt , B ou Sn exibem potencial para fármacos antineoplásicos. Diversos complexos de Pt têm sido estudados como agentes antiproliferativos desde a aprovação do uso clínico da cisplatina, cis-[PtCl2(NH3)2], pelo FDA (Food and Drug Administration), no final da década de 1970. Cisplatina ainda é, hoje em dia, o principal anticancerígeno com Pt. Também é crescente o interesse na atividade biológica de moléculas com boro. Elas têm sido investigadas com o agentes anticancerígenos e antimicrobianos. Bortezomib é um medicamento antineoplásico contendo um ácido borônico , [R-B(OH)2], como princípio ativo. Alguns complexos de Sn exibem atividade antiproliferativa maior que aquela observada para cisplatina ou outras drogas inorgânicas. Por isso, a procura por a gentes anticancerígenos com Sn, sobre tudo organoestânicos(IV), tem crescido nas últimas décadas. Fármacos com Pt, B e Sn exibem, geralmente, vários efeitos colaterais. Portanto, ainda existe a necessidade do desenvolvimento de fármacos que causem menos efeitos secundários e consigam contornar mecanismos de resistência tumoral. O desenho racional e o desenvolvimento de novas drogas utilizam-se do atracamento molecular (docking), que busca avaliar a afinidade de um ligante pelo sítio de ligação da proteína-alvo, seja ele ortostérico ou alostérico. DockThor é um programa de atracamento molecular com portal web acoplado ao uso do supercomputador SDumont para triagem virtual em larga escala (http://www.dockthor.lncc.br). Ele adota uma função de avaliação baseada no campo de força MMFF9 4 S. Nele, não há parâmetros para moléculas com Pt, B ou Sn. Este projeto, portanto, visa à obtenção de parâmetros intra e intermoleculares, incluindo constantes de força e cargas atômicas, baseados nesses elementos em compostos biologicamente ativos, empregando cálculos HF, MP2 e DFT, e à implementação desses parâmetros nos campos de força MMFF9 4 S e AMBER. Esta proposta objetiva o desenvolvimento de uma versão do DockThor capaz de avaliar poses para compostos de Pt, B ou Sn, ampliando a sua capacidade preditiva, e aprovisão de parâmetros que permitam simulações clássicas usando AMBER. Nesta proposta, visando à derivação de novos parâmetros para ambos campos de força, está prevista a análise de cerca de 2700 moléculas. Isso viabilizaria o uso conjunto de docking e DM para o desenho de novas drogas com Pt, B e Sn. |

|

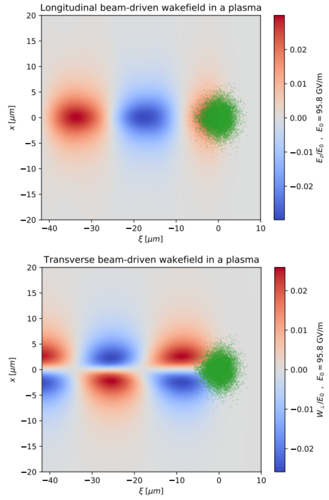

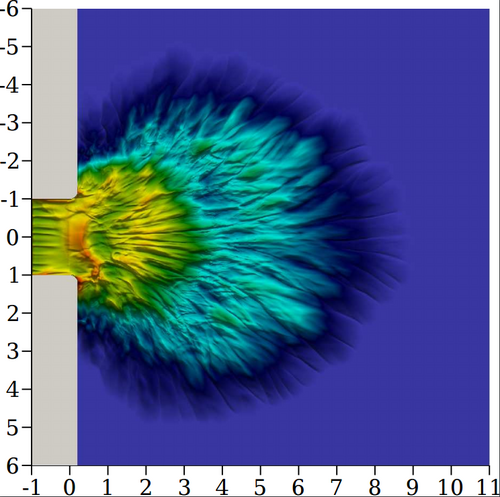

Desaceleração de feixes de partículas carregadas por campo elétrico de rastro (bdwf) Universidade Federal do Rio Grande do Sul Departamento de Engenharia Elétrica Coordenador: Roger Pizzato Nunes Áreas do conhecimento: Física Início da vigência: 19-07-2019 A técnica de aceleração de partículas carregadas por indução de um campo de rastro em um plasma representou um dos maiores avanços na área de feixes de partículas carregadas. A possibilidade de acelerar feixes a energias da ordem dos GeV em apenas alguns centímetros no canal de aceleração permitiu o projeto e o desenvolvimento de máquinas mais potentes e compactas. A potência é um fator importante em aplicações científicas dos feixes de partículas carregadas, tais como investigação da estrutura da matéria, enquanto a compacticidade é relevante nas aplicações na área da medicina, engenharia de materiais, industriais, dentre outras. Da mesma forma que o campo elétrico de rastro produzido em um plasma pode ser utilizado para acelerar partículas de sorte a compor um feixe altamente energético, tal campo elétrico de rastro pode ser também utilizado para desacelerar os feixes, após sua utilização na aplicação pretendida. Desacelerar os feixes é importante pois partículas altamente energéticas causam a radioativação da estrutura, sendo os estágios desaceleradores também responsáveis em ocupar grande parte da máquina. Se o campo elétrico de rastro pode ser utilizado para acelerar as partículas carregadas às altas energias pretendidas em curtas distâncias, tal campo elétrico de rastro também pode ser utilizado para desacelerar os feixes altamente energéticos em também curtas distâncias, tornando as estruturas necessárias ao descarte do feixe extremamente diminutas. Nesses termos, o objetivo do presente trabalho é simular numericamente a desaceleração de feixes de partículas carregadas mediante o campo de rastro produzido. Os resultados obtidos serão comparados com resultados analíticos. |

|

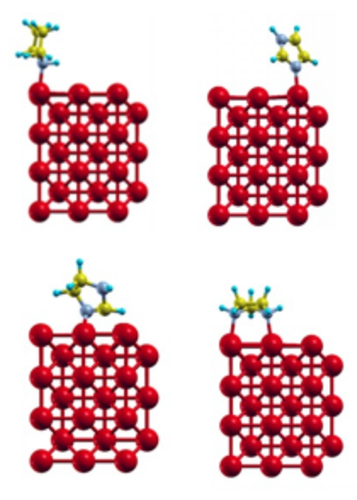

Desenho de novos inibidores azólicos de corrosão de metais (chaer2sd) Universidade Federal do Rio de Janeiro Departamento de Físico-Química Coordenador: Marco Antonio Chaer do Nascimento Áreas do conhecimento: Ciência dos materiais; Química Início da vigência: 02-06-2017 A corrosão é um problema severo na indústria, responsável por perdas de bilhões de dólares por ano. Os gastos com corrosão nos Estados Unidos chegaram a cerca de 400 bilhões de dólares, o equivalente a 3 % do PIB do país, enquanto que no Brasil os gastos correspondem a 3,5 % do PIB. Em consequência disso, há uma grande atividade de pesquisa na área de corrosão, principalmente na busca por bons inibidores, já que este é o meio mais efetivo, econômico e flexível de controle da corrosão interna. Entretanto, a grande maioria das pesquisas nesta área é conduzida de forma empírica, na base da “tentativa e erro”, ou quando muito explorando relações do tipo estrutura do inibidor e sua eficiência. Esses procedimentos, além de muito caros e lentos, pouco contribuem para o entendimento da natureza do problema, ou seja, do mecanismo de corrosão, e consequentemente para o desenvolvimento de novos e mais eficientes inibidores de corrosão. Neste trabalho propomos uma abordagem teórico-experimental para entender o mecanismo de ação dos inibidores já conhecidos e projetar novos inibidores, mais eficientes e ambientalmente corretos. O mecanismo de adsorção será estudado através de cálculos quanto-mecânicos, periódicos e não periódicos, que nos permitirão entender de que forma o inibidor interage com a superfície metálica e o mecanismo de proteção da superfície. Esses estudos permitirão também determinar se há formação de filmes superficiais e as características desses filmes, dados importantes para a determinação do grau de recobrimento da superfície e, portanto, da concentração do inibidor a ser usada. As moléculas mais promissoras serão sintetizadas e testadas experimentalmente, quanto à sua eficiência de inibição, por meio de técnicas convencionais de perda de massa, medida de potencial de corrosão, e por técnicas eletroquímicas mais sofisticadas, tais como diagramas de impedância eletroquímica e microscopia eletroquímica de varredura. Os cálculos serão feitos em nível DFT, com condições periódicas de contorno, base de ondas planas e pseudopotenciais, utilizando o programa Quantum Espresso para realizar o estudo da interação das moléculas com as superfícies em diferentes graus de oxidação (Figura 4). Para cada potencial inibidor será feito um estudo sistemático para verificar como uma molécula se adsorve preferencialmente na superfície, como o processo de adsorção varia com o número de moléculas adsorvidas, o grau de recobrimento máximo que pode ser obtido com cada potencial inibidor e a distribuição das moléculas na superfície no regime de recobrimento máximo (formação de filme, empilhamento etc.) Essas informações guiarão as sínteses para obtenção e testes dos potenciais inibidores. Em cada caso, a estabilidade da camada protetora será testada adicionando-se algumas poucas moléculas de água ao sistema. As seguintes moléculas e seus derivados serão considerados no presente estudo: imidazol, imidazolina, imidazolidina e pirrolidina. O estudo da interação de uma única molécula de cada espécie com a superfície (001) de Fe já foi concluído. |

|

Desenvolvimento de funcionalidades, aumento da escalabilidade e estudos numéricos com modelos atmosféricos de alta resolução: BRAMS e OLAM (bramsolam) Universidade de São Paulo Instituto de Astronomia, Geofísica e Ciências Atmosféricas Coordenador: Pedro Leite da Silva Dias Áreas do conhecimento: Meteorologia Início da vigência: 28-06-2016 O modelo meteorológico regional utilizado nesse trabalho de equipe partiu do Regional Atmospheric Modeling System, inicialmente desenvolvido na Colorado State University, e passou por drásticas modificações, visando o paralelismo massivo, novas funcionalidades que melhor representam os fenômenos meteorológicos tropicais e acoplamento com a biosfera, oceanos, áreas inundadas, efeitos da emissão de aerossóis urbanos e por queimadas, química da atmosfera, com ênfase nos efeitos urbanos, emissões biogênicas etc. (Freitas et al. 2009). Somente como referência, foi o esforço brasileiro que elevou a escalabilidade da versão americana (RAMS) de algumas poucas centenas de núcleos para mais de 10.000 cores na versão brasileira denominada BRAMS – Brazilian Developments on the Regional Atmospheric Model (Souto et al. 2015). Mais recentemente, uma iniciativa nos EUA levou ao desenvolvimento de um modelo de domínio global, com núcleo dinâmico inovador, baseado em discretização por volumes finitos, e com toda a formulação dos processos físicos do RAMS/BRAMS, incluindo soluções numéricas e computacionais para garantir maior escalabilidade em plataformas computacionais de processamento massivamente paralelo. Esta versão é denominada OLAM – Ocean Land Atmosphere Model (Walko et al. 2008). Hoje, no Brasil, é feito um esforço integrado entre CPTEC/INPE, IAG/USP, LNCC, IME/USP, UFCG, UFSC e EMBRAPA de desenvolvimento do modelo e com uso para validação e operação na FUNCEME, UFRJ, UFSM, UFPA, INPA, UEA e vários centros regionais de Meteorologia através de um projeto de encomenda do MCTI. A proposta de uso do Santos Dumont no projeto BRAMS/OLAM tem os seguintes focos: 1. Paralelização: (a) OLAM - trabalho desenvolvido principalmente no LNCC com a participação do Dr. Jairo Panetta (ITA) que visa aumento de escalabilidade e migração de algumas partes do modelo para GPU e XEON-PHI e (b) BRAMS – trabalho desenvolvido principalmente pelo Dr. Jairo Panetta do ITA com parceira do CPTEC, LNCC e IAG, também visando o aumento da escalabilidade com foco nas aplicações operacionais do modelo. 2. Utilização do BRAMs/OLAM nas seguintes linhas de pesquisa: 2.1 Assimilação de dados de microfísica da precipitação no BRAMS 2.2 Acoplamento do BRAMS a um sistema de assimilação de dados convencionais e de satélite através do sistema GSI 2.3 Circulações locais na Amazônia e organização da precipitação com malhas de alta resolução no OLAM com ênfase no efeito das áreas alagadas: 2.4 Análise dos erros de previsões de tempo com alta resolução no BRAMS e OLAM do campo de vento para aplicações no gerenciamento de parques eólicos 2.6 Melhorias da funcionalidade do acoplamento com aerossóis e gases traço no BRAMS 2.7 Acoplamento do BRAMS com processos oceânicos 2.8 Efeito do acoplamento troposfera/estratosfera através do ozônio no OLAM. |

|

Desenvolvimento de Métodos Teóricos para o estudo da relação estrutura-funcionalidade em Biomoléculas (dynemol_ufsc) Universidade Federal de Santa Catarina Departamento de Física Coordenador: Luís Guilherme de Carvalho Rego Áreas do conhecimento: Ciência da computação; Física; Química Início da vigência: 17-12-2018 O objetivo geral deste projeto é estudar os mecanismos microscópicos responsáveis pelo transporte de carga e energia em biomoléculas e proteínas, bem como desenvolver métodos teórico/computacionais para elucidar o papel das coerências clássicas e quanticas na funcionalidade de sistemas biofísicos. Uma das perguntas centrais que pretendemos responder com essa pesquisa é: De que modo a energia de um fóton, ou de uma ligação química, é convertida em energia útil para o funcionamento de um organismo vivo? Em muitos casos, a absorção de um fóton desencadeia uma sequência de processes ultra-rápidos de transferência eletrônica, como ocorre nos primeiros estágios da fotossíntese, por exemplo. A energia potencial dos fragmentos oxidados ou reduzidos pela transferência eletrônica, por sua vez, induz transporte de ions e a formação de novos compostos. Tais processos de transferência eletrônica, em muitos casos, envolvem o movimento coordenado de elétrons e núcleos e o tunelamento eletrônico entre centros doadores e aceitadores localizados na proteína. O tunelamento eletrônico é facilitado pelo fenômeno de super-exchange (tunelamento através de estados virtuais) pois a proteína é essencialmente isolante. Um dos desafios centrais desse campo de pesquisa é entender como a estrutura da proteína, que circundeia os estados doador e aceitador, assim como sua dinâmica influenciam a transferência eletrônica de longo alcance nas proteínas. Dentre os problemas de interesse estão: (1) transferência de carga e energia em sistemas moleculares, (2) transdução fotoinduzida em sistemas moleculares, (3) efeitos quânticos em dinâmica molecular, (4) coleta e conversão de energia luminosa em sistemas naturais e sintéticos. O grupo Dinemol desenvolvemétodos híbridos do tipo QMMM (Quantum Mechanics/Molecular Mechanics) capazes de descrever efeitos de acoplamento elétron-núcleo em sistemas moleculares complexos. Os métodos computacionais desenvolvidos pelo grupo estão implementados no programa Dynemol, de livre acesso em https://github.com/lgcrego/Dynemol. O programa faz uso intenso de processamento paralelo através dos protocolos openMPI e MPI, além de GPU. |

|

Detecção de plágio multilíngue em artigos biomédicos (dpm) Universidade Federal do Rio Grande do Sul Engenharia de Produção Coordenador: Michel Jose Anzanello Áreas do conhecimento: Ciência da computação; Engenharias; Linguística, letras e artes Início da vigência: 21-06-2018 Plágio é a utilização do trabalho de uma terceira pessoa sem o devido reconhecimento ou citação, sendo um dos principais problemas na academia e na ciência. Este comportamento antiético está crescendo rapidamente, alimentado especialmente pela facilidade em compartilhar e recuperar informações através da internet. O desenvolvimento de soluções para detecção automática de plágio (PD) pode auxiliar humanos na identificação de conteúdos possivelmente copiados, além da sua fonte, mas também devem ser capazes de identificar casos de plágio multilíngue, o qual está se tornando recorrente, especialmente pelo fato de ferramentas de tradução automática atuais atingirem performance excepcional. Esta proposta de pesquisa vise desenvolver novas abordagens para detecção de plágio multilíngue em artigos biomédicos, dado que esta área científica em alto crescimento pode beneficiar-se de métodos que levem em consideração as características e terminologias não usualmente vistas em outras áreas científicas. Inicialmente, esta pesquisa irá focar no uso de ferramentas de tradução neural para derivar word embeddings, os quais serão utilizados para computar a similaridade semântica textual entre segmentos. O principal output no estágio inicial será a criação de modelos de tradução utilizando deep learning. Tais modelos tem cada vez mais se mostrado superiores aos tradicionais métodos estatísticos, porém requerem alto poder computacional. Atualmente não existe modelo de tradução já treinado para área biomédica, além dos tradutores disponíveis (ex: Google e Bing) não terem API gratuita. |

|

DockThor-VS: Web Server para Triagem Virtual de Fármacos em Larga Escala (dockthorvs) Laboratório Nacional de Computação Científica Coordenação de Mecânica Computacional Coordenador: Laurent Emmanuel Dardenne Áreas do conhecimento: Ciências biológicas Início da vigência: 17-08-2016 Técnicas computacionais, conhecidas como atracamento molecular (do inglês, molecular docking), que sejam capazes de prever o modo de ligação e os detalhes do tipo de reconhecimento molecular proteína-ligante, assumem cada vez mais um papel fundamental em áreas estratégicas de pesquisa associadas à saúde e à biotecnologia, que podem envolver centenas de milhões de dólares. Cada vez mais, indústrias farmacêuticas e grupos de pesquisa, que trabalham na busca de novas moléculas candidatas a fármacos, necessitam de metodologias mais rápidas, eficazes e de baixo custo. Neste cenário, a triagem virtual em larga escala baseada na estrutura tridimensional do receptor tem se destacado como uma importante ferramenta na busca de compostos protótipos. A triagem virtual baseada em estrutura consiste em analisar computacionalmente uma grande quantidade de ligantes com o objetivo de selecionar, de acordo com os modos de ligação e as afinidades de ligação previstos, compostos provavelmente mais ativos farmacologicamente para determinada doença. Nos últimos doze anos o Grupo de Modelagem Molecular de Sistemas Biológicos do Laboratório Nacional de Computação Científica (LNCC) tem desenvolvido o programa DockThor para predição de complexos moleculares receptor-ligante. Mais recentemente foi lançado em nível nacional, na 65a Reunião Anual da Sociedade Brasileira para o Progresso da Ciência (SBPC), o Portal web DockThor (www.dockthor.lncc.br), disponibilizando gratuitamente para a comunidade acadêmica o primeiro programa brasileiro (e possivelmente de todo o hemisfério sul) de atracamento molecular receptor-ligante. O portal está acoplado às facilidades de computação de alto-desempenho do SINAPAD. Desde o seu lançamento o portal DockThor foi acessado por mais de 3.500 visitantes únicos e teve cerca de 3500 jobs submetidos. Com a instalação do supercomputador brasileiro Santos Dumont abre-se uma oportunidade excepcional para o desenvolvimento de uma plataforma computacional, envolvendo metodologias e programas próprios, para triagem virtual em larga escala de compostos candidatos a fármacos que possa ser utilizada por grupos de pesquisa e empresas brasileiras atuantes nas áreas de química medicinal e biotecnologia. O presente projeto objetiva implementar a primeira etapa do desenvolvimento do portal web DockThor-VS (VS de virtual screening) para triagem virtual em larga escala acoplado ao Santos Dumont. A versão atual do portal DockThor permite apenas realizar experimentos computacionais envolvendo um ligante e um receptor por vez. No DockThor-VS será possível investigar bibliotecas de ligantes contendo milhões de moléculas contra dezenas ou até mesmo centenas de alvos moleculares. É importante ressaltar que pesquisadores ligados a este projeto são membros do INCT-INOFAR (Instituto Nacional de Ciência e Tecnologia de Fármacos e Medicamentos - http://www.inct-inofar.ccs.ufrj.br/) onde desenvolvem pesquisas aplicadas de desenho racional de fármacos através de fortes colaborações com grupos de pesquisa e instituições relevantes na área de desenvolvimento de novos fármacos para o tratamento de doenças negligenciadas, Alzheimer e inflamatórias crônicas. |

|

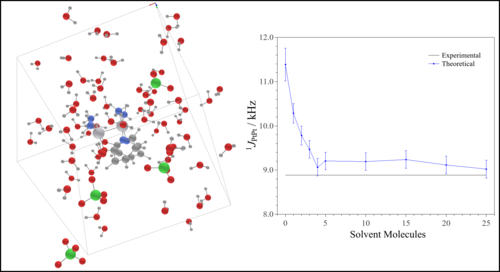

Efeito do solvente em complexos dinucleares de platina(III) via dinâmica molecular ab initio e cálculos de tensores blindagem e constante de acoplamento spin-spin (aimdsolv) Universidade de São Paulo Instituto de Química Coordenador: Lucas Colucci Ducati Áreas do conhecimento: Física; Química Início da vigência: 25-06-2018 Complexos de diplatina platina (Pt-Pt) e derivados vem sendo investigados para potenciais aplicações como drogas antitumorais devido às suas baixas associaçõescom nefrotoxicidade. Estes compostos apresentam relevâncias tecnológicas, como propriedades magnéticas, ópticas, quantum dots, bem como, processos industriais catalíticos. No entanto, a compreensão estrutural e espectroscópica destes compostos é ainda muito limitada em solução, o que carece de novas metodologias que forneçam melhores informações, principalmente em solução, onde grande parte dos complexos são sintetisados, acarretando melhor entendimento para futuras aplicações tecnológicas. A Ressonância Magnética Nuclear (RMN), a técnica mais poderosa para determinação estrutural em solução, tem em seus parâmetros tensor blindagem (σ)/deslocamento químico (δ), e as constantes de acoplamento (J) fontes de informação para determinação inequívoca da estrutura molecular, dependendetes da estrutura molecular e eletrônica que é fortemente perturbada pela sovatação. Para melhor elucidar a dinâmica da estrutura soluto solvente e como muda a densidade eletrônica dos complexos Pt-Pt, cálculos de dinâmica molecular ab initio e da teoria do funcional de densidade serão aplicados neste estudo, para simulação das espécies em solução. Estudos prévios com solvatação implícita anteriores sugerem que a descrição explícita do sistema soluto-solvente de forma dinâmica, possibilitará a descrição mais realista das condições experimentais, melhorando a precisão dos valores de σ, δ e J com geometrias estáticas em nível DFT, com inclusão de efeito de solvente implícito e Hamiltoniano com correção relativística, superestimam os valores experimentais em cerca de 100% para a maioria dos compostos. Para isso, a dinâmica molecular de Kohn-Sham (KS) Car-Parrinello (CPMD) e cálculos KS híbridos de propriedades magnéticas, com e sem efeito de solvente, serão utilizados. Este projeto propõe uma nova aplicação estado da arte no estudo dos parâmetros espectroscópicos e da dinâmica soluto solvente e estruturais em solução, o que auxiliará na elucidação do comportamento catalítico e outras propriedades em que o papel do solvente é fundamental. |

|

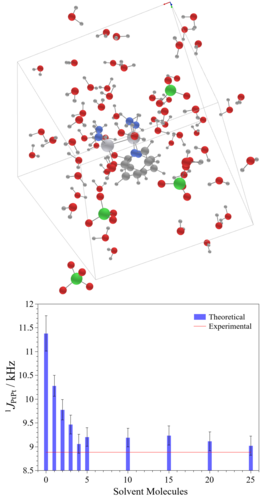

Efeito do Solvente em Parâmetros Espectroscópicos de RMN por Dinâmica Molecular ab initio (nmrmd) Universidade de São Paulo Instituto de Química Coordenador: Lucas Colucci Ducati Áreas do conhecimento: Física; Química Início da vigência: 03-08-2018 Ressonância Magnética Nuclear (RMN) é a técnica mais poderosa para determinação estrutural em solução. Os parâmetros como tensor blindagem (σ)/deslocamento químico (δ), e as constantes de acoplamento (J) são as fontes mais importantes de informação para determinação inequívoca da estrutura molecular e conformação adotada por uma molécula em solução. δ e J dependem da estrutura molecular e eletrônica, e serão suportados por valores calculados através da mecânica quântica. Nesta proposta são avaliados o efeito de sovatação da água e, principalmente, a contribuição da ligação de hidrogênio entre solvente-soluto no δ de 14N de compostos nitrogenados. Estudos teóricos usando modelos de solvatação implícita anteriores sugerem o uso de solvatação explícita e a descrição do sistema soluto-solvente de forma dinâmica, a fim de obter uma descrição mais realista das condições experimentais, melhorando a precisão dos valores estimados. Além disso, influência da coordenação do solvente (água) sobre o σ, δ e J de complexos Pt-Pt, precursores dos sais de Magnum, também será alvo de estudo. Esses complexos se encontram em equilíbrio em meio aquoso, sendo necessário o uso de sovatação explícita e uma descrição do sistema soluto-solvente de forma dinâmica. Os valores teóricos de σ, δ e J com geometrias estáticas em nível DFT, com inclusão de efeito de solvente implícito e Hamiltoniano com correção relativística, superestimam os valores experimentais em cerca de 100% para a maioria dos compostos. Para isso, a dinâmica molecular de Kohn-Sham (KS) Car-Parrinello (CPMD) e cálculos KS híbridos de propriedades magnéticas, com e sem efeito de solvente, serão utilizados. Esta nova técnica computacional, aliando KS-CPMD e cálculos KS-DFT híbridos para determinação de propriedades magnéticas, foi proposta e desenvolvida durante os últimos 2 anos durante o estágio de pesquisa deste proponente no exterior, e tendo sido aplicada com sucesso para compostos de metais de transição Tl-Pt. Este projeto propõe uma nova aplicação desse tipo de estudo de parâmetros espectroscópicos em solução, com o intuito de consolidar uma nova linha de pesquisa, inédita no país, bem como melhorar a formação em alto nível dos alunos. Há uma forte colaboração com grupos experimentais do IQ/USP e um do exterior. |

|

Efeitos isotópicos sobre as propriedades elétricas de isotopólogos moleculares: aplicações em astroquímica e nanociência (isotope) Centro Federal de Educação Tecnológica de Minas Gerais Coordenação de Área de Ciências Coordenador: Antônio Francisco Cruz Arapiraca Áreas do conhecimento: Astroquímica; Física; Química Início da vigência: 25-01-2019 Neste projeto pretendemos realizar um estudo teórico e computacional, utilizando cálculos ab initio e de teoria do funcional densidade, do efeito isotópico sobre propriedades elétricas de diversos sistemas de isotopólogos moleculares de larga escala como hidrocarbonetos aromáticos policíclicos (PHA), fulerenos funcionalizados e complexos endoedrais. O estudo destas propriedades será feito na perspectiva de aplicações nos contextos de astroquímica e nanociência. No caso astroquímico, por exemplo, intensidades de transições do espectro rotacional puro, de modo a prover informações que auxiliem observações via radiotelescópios, podem ser obtidas a partir dos momentos dipolares calculados para um conjunto de hidrocarbonetos aromáticos policícliclos deuterados (PAD) e fulerenos funcionalizados com hidrogênios e deutérios. Na seara da nanociência, além do efeito isotópico sobre os momentos dipolares de complexos de fulerenos endoedrais, pretendemos quantificar o efeito de blindagem devido à polarização dipolar que o sistema hospedeiro sofre devido à presença do sistema hóspede polar. Para tal estudo utilizaremos uma correção adiabática variacional de uso generalizado, que tem capacidade de computar os efeitos de massa nuclear finita que implicam em quebra de simetria por substituição isotópica, em conjunto com uma metodologia perturbativa que leva em conta correções vibracionais que consideram o campo de força anarmônico e os desvios da linearidade das propriedades moleculares. Essa metodologia já fio capaz de calcular, com boa acurácia na comparação com dados experimentais, os momentos dipolares para uma gama considerável de moléculas poliatômicas. |

|

Engenharia de Proteínas e Biomiméticos com Potencial em Diagnóstico e Vacinal para os Vírus Dengue e ZIKA (biomatdesign) Centro de Pesquisas Aggeu Magalhães, Fundação Oswaldo Cruz Virologia Coordenador: Roberto Dias Lins Neto Áreas do conhecimento: Ciências biológicas; Química Início da vigência: 10-10-2019 A detecção de antígenos e anticorpos específicos de patógenos é um dos métodos mais utilizados em diagnóstico clínico. Tal procedimento é utilizado no diagnóstico de câncer, doenças infecciosas, autoimunes, etc. Além disso, as moléculas de anticorpos constituem o mecanismo de proteção biosintética mais efetivo. Um aspecto crítico e até mesmo limitante para a síntese de anticorpos altamente específicos é o fato de que alguns epítopos podem se apresentar de forma transiente, expondo-se apenas quando o vírus se liga ao receptor. Uma alternativa para tal problema é a engenharia de estruturas moleculares (proteínas naturais ou biomiméticos) que possam servir de suporte para tais epítopos. De natureza multidisciplinar, métodos de simulação computacional serão sinergisticamente associados a técnicas experimentais de biologia molecular, imunologia e biofísica molecular para o desenvovimento de moléculas potencialmente imunorreativas. Especificamente, este projeto tem por objetivo o desenho racional e a caracterização das bases moleculares de proteínas e biomiméticos de interesse imunológico (diagnósticos e vacinais) que tem como alvo os vírus Dengue e ZIKA. O desenvolvimento dessas novas moléculas podem contribuir não apenas na área de saúde publica, mas também para a redução da nossa dependência tecnológica, a partir da produção de insumos com tecnologias estritamente nacionais. |

|

Ensino de Computação de Alto Desempenho - HPC - na graduação do curso de Sistemas de Informação (hpcfai) FAI - Centro de ensino Superior em Gestão, Tecnologia e Educação Departamento de Informática Coordenador: Fábio Gavião Avelino de Méllo Áreas do conhecimento: Ciência da computação; Sistemas de informação Início da vigência: 23-07-2019 O fator inovador do presente projeto consiste na disseminação da computação de Alto desempenho - HPC - para alunos de graduação em Sistemas de Informação e cursos afins. Espera-se com a iniciativa despertar o interesse de estudantes para esta área. O amadurecimento do ensino desta disciplina gerará novos projetos de Iniciação Científica, despertará o interesse de diversos cursos de extensão em replicar a disciplina nos mesmos e também em cursos de pós-graduação strictu sensu e lato sensu na região. É esperado também que haja a criação de projetos para empresas focadas em tecnologia que poderão ter interesse em usar HPC para seus projetos de Inteligência Artificial e Sistemas de Apoio a Decisão como, por exemplo, os que usam Otimização Combinatória. |

|

Estimação Não Invasiva de Reserva Fracionada de Fluxo Coronário FFR (hmlffr2) Laboratório Nacional de Computação Científica Coordenação de Métodos Matemáticos e Computacionais Coordenador: Pablo Javier Blanco Áreas do conhecimento: Ciências da saúde; Engenharias Início da vigência: 26-09-2019 O objetivo do presente projeto é dar continuidade às atividades de pesquisa e desenvolvimento sobre técnicas de modelagem computacional e simulação numérica na área de hemodinâmica computacional do sistema cardiovascular humano. Este projeto constitui a continuação do projeto do mesmo nome, que for a aprovado no ano 2017. Especificamente, o projeto visa o desenvolvimento de modelos baseados em dinâmica de fluidos computacional e modelos de dimensão reduzida para realizar o cálculo numérico da reserva fracionada de fluxo coronário. Isto é, desenvolver métodos numéricos para estimar índices fluidodinâmicos associados à presença de lesões de caráter obstrutivo em artérias coronárias, e a partir disto realizar a análise de risco de isquemia miocárdica. Na versão anterior do projeto foram desenvolvidos modelos orientados para pacientes específicos para simular a circulação na árvore coronariana podendo considerar presença de estenoses e o efeito de vasodilatadores, sendo que foram realizados diversos estudos, tais como o desenvolvimento de modelos 1D (ver produção) em detrimento do estudo do efeito de vasos colaterais. Nesta fase do projeto, procar-se-á validar, frente a modelos 3D completos, a capacidade de predição de modelos de compartimentos (modelos 0D) e modelos 1D enriquecidos (modelos 1D+). Como no projeto anterior, a anatomia vascular coronária de cada paciente será obtida a partir do processamento e segmentação de imagens médicas. Em segundo lugar, estes modelos geométricos serão empregados para estimar índices cardiovasculares de interesse médico utilizando diferentes modelos matemáticos, e avaliar o risco de isquemia em pacientes com doença coronária. Ainda, realizar-se-á um estudo com uma população de pacientes mais ampla, podendo chegar a superar a centena de casos de estudo. Espera-se que os resultados alcançados com este trabalho venham a fornecer ferramentas não invasivas, com grau de confiabilidade equivalente às técnicas invasivas, que auxiliem na avaliação de risco de isquemia de miocárdio em pacientes com doença coronária. |

|

Estrutura eletrônica e transporte em nanodispositivos de baixa dimensionalidade (nanosys) Universidade Estadual Paulista Júlio de Mesquita Filho Departamento de Engenharia Mecânica Coordenador: Ricardo Paupitz Barbosa dos Santos Áreas do conhecimento: Física Início da vigência: 02-01-2020 O presente projeto propõe o aprofundamento de estudos realizados a respeito de sistemas nanoscópicos, especialmente os bi-dimensionais, realizados nos últimos anos no laboratório de simulação computacional do departamento de Física da Unesp de Rio Claro. A proposta de uso dos recursos de computação de alto desempenho disponíveis no Santos Dumont visa permitir o cálculo de propriedades estruturais e eletrônicas de sistemas bidimensionais que têm potencial para a construção de novos nanodispositivos semicondutores baseados em novos materiais que o grupo vem estudando nos últimos 7 anos. O projeto conta com a colaboração científica do grupo do prof. Adri C. T. van Duin (Penn State University), criador do potencial ReaxFF e com a colaboração do Prof. Pekka Koskinen, da Universidade de Jyvaskyla (Finlândia). A contribuição do Prof. Koskinen estará, principalmente no desenvolvimento de novos parâmetros para a aproximação Tight Binding Density Functional Theory (DFTB) que utilizaremos de modo intenso durante o projeto. O DFTB, por ser uma aproximação do DFT, nos permite obter informações de caráter quântico sobre estruturas com grande número de átomos (centenas ou milhares, dependendo dos recursos computacionais disponíveis). Os recursos solicitados no presente projeto são essenciais para possibilitar que sejam realizadas buscas exaustívas para determinar as relações entre propriedades estruturais e propriedades eletrônicas dos materiais e dispositivos de interesse. Propomos o estudo de junções entre materiais semicondutores estruturalmente relacionados com o grafeno, como o Grafenileno (recentemente sintetizado por dois grupos experimentais diferentes)e versões modificadas, seja por dopagem seja por modificações geométricas a fim de determinar se seria possível controlar de algum modo o transporte eletrônico ou outros efeitos eletromecânicos, como a peizoeletricidade. Para a realização de tais estudos é necessário desenvolver novos parâmetros DFTB para os elementos químicos envolvidos e o uso dos recursos solicitados no presente projeto será determinante para o sucesso do estudo em tempo razoável. Como possíveis aplicações práticas temos a possibilidade de serem produzidos em laboratório, tendo em vista que parte dos materiais propostos já foram obtidos experimentalmente por diferentes grupos internacionais de pesquisa. |

|

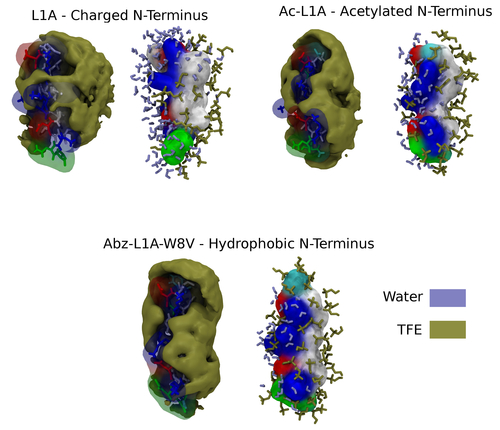

Estudo da interação de peptídeos antimicrobianos (PAMs) com modelos de membrana celular por simulações de Dinâmica Molecular (antimicmd2) Universidade Estadual Paulista Júlio de Mesquita Filho Departamento de Física Coordenador: Alexandre Suman de Araujo Áreas do conhecimento: Ciência da computação; Ciências biológicas; Física Início da vigência: 28-06-2019 A descoberta de fármacos capazes de combater bactérias, os antibióticos, representou uma revolução na medicina, salvando milhões de vidas e contribuindo para um incremento significativo na qualidade e expectativa de vida do ser humano. Entretanto, o uso indiscriminado desse medicamento vem selecionando cepas bacterianas resistentes a um amplo espectro de antibióticos. Assim, o desenvolvimento de novos medicamentos que atuem por vias antibióticas ainda não exploradas e, principalmente, de difícil adaptação, é de grande interesse na atualidade. Os peptídeos antimicrobianos (PAM) são pequenas particulas proteicas produzidas pelo sistema imune de alguns animais e vegetais e que apresentam ação, além de bactericida, contra vírus, fungos e células cancerosas. Os PAMs, que são catiônicos em pH fisiológico, etuam sobre a membrana celular das bactérias, a qual é constituída de fosfolipídeos aniônicos, induzindo poros e vazamento do conteúdo celular (lise celular). Como a constituição da membrana celular é uma característica fundamental em todo ser vivo, mutações que resultem em resistências aos PAMs são raras e inviáveis, indicando que a via antibiótica dos PAMs tem grande potencial de exploração. O crescimento vertiginoso no poder computacional observado nas últimas décadas, tanto em nível de software como de hardware, permitiu a aplicação de técnicas de simulação computacional, antes restritas a sistemas simples e com poucos elementos, a sistemas biológicos complexos. Esse avanço colocou as simulações computacionais de sistemas biológicos em pé de igualdade com as mais tradicionais técnicas experimentais de investigação em biofísica, de modo que, atualmente, grande parte dos trabalhos nessa área utilizam técnicas experimentais e computacionais, colaborativamente, para descrever e entender os sistemas de interesse. Dentre a miríade de métodos de simulações computacionais existentes, o mais utilizado atualmente para o estudo de sistemas contendo moléculas biológicas é a Dinâmica Molecular (DM) e suas variantes. Esse método fornece resultados precisos e confiáveis, além de amostrar de forma satisfatória o enorme conjunto de conformações que as biomoléculas podem assumir, o que é exigência básica para o cálculo de propriedades macroscópicas a partir de informações do sistema microscópico. O fato das conformações amostradas pela DM estarem conectadas no tempo, na forma de uma trajetória, permite a obtenção de uma gama de propriedades do sistema que vão desde a conformação mais provável (de equilíbrio) até correlações temporais de propriedades coletivas. No presente projeto propomos o estudo do processo de adsorção e ação de PAMs naturais e sintéticos sobre bicamadas lipídicas, usadas como modelo de membrana celular, por meio de simulações de Dinâmica Molecular no equilíbrio, cálculos de energia livre e Dinâmica Molecular a pH Constante. A observação, em nível atômico/molecular, das interações peptídeo/bicamada e a conformação que assumem em diferentes situações físico-químicas podem nos fornecer indícios das propriedades fundamentais dos peptídeos que lhes conferem capacidade bactericida, o que é fundamental para o desenvolvimento de novos antibióticos mais potentes, eficazes e com baixa propensão e gerar cepas resistentes. |

|

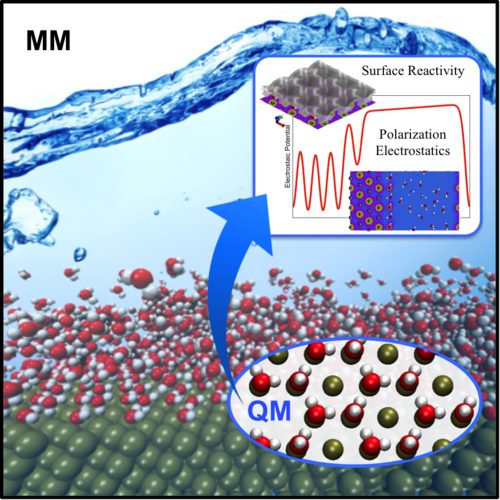

Estudo de Água em Interfaces Eletroquímicas (watredox) Universidade Federal do ABC Centro de Ciências Naturais e Humanas Coordenador: Mauricio Domingues Coutinho Neto Áreas do conhecimento: Ciência dos materiais; Física; Química Início da vigência: 16-07-2018 Interfaces eletroquímicas são componentes fundamentais em diversas aplicações tecnológicas. Desta maneira, o entendimento e controle dessas interfaces a nível microscópico é essencial para o desenvolvimento e consolidação de tecnologias como sistemas fotovoltáicos, sensores biológicos, etc. Particularmente, considerando que na maioria dos processos eletroquímicos, tais como eletrólise e eletrocatálise, tem-se água na forma de solvente ou reagente, é de extrema importância compreender os processos cinéticos e reações que ocorrem nas interfaces envolvendo água e eletrodos, bem como compreender as propriedades microscópicas da água. Assim, o uso de simulações atomísticas se torna fundamental para se obter uma compreensão mais detalhada em nível atômico e molecular. Considerando a natureza quântica dos fenômenos que ocorrem em interfaces eletroquímicas, simulações de primeiros princípios precisam ser consideradas. Nesta proposta propomos abordar duas questões de natureza fundamental para descrição de processos em eletrodos metálicos. No primeiro estudo propomos desenvolver e aplicar protocolos computacionais multiescala baseados em métodos QM/MM e cálculos de dinâmica molecular ao estudo de interfaces eletroquímicas envolvendo água e eletrodos metálicos de interesse para aplicações em energia e sensores biológicos. A motivação para o uso de métodos híbridos QM/MM e abordagens multiescala é a de contornar limitações de escala e tempo tipicamente presentes em simulações ab-initio. Simultaneamente pretendemos estudar as propriedades da água líquida e na interface com eletrodos metálicos utilizando técnicas de Machine Learning. Para aplicações em física, ML permite descobrir quais são as leis que produziram os dados usados no treinamento sem ter que assumir nenhuma forma específica para estas a priori, uma grande vantagem em relação aos processos de ajuste convencionais, nos quais se dá exatamente o oposto. Esta flexibilidade é importante no ajuste de funções (ou leis) complexas, como superfícies de energia potencial, pois permitem que a rede neural capte comportamentos sutis e difíceis de perceber, gerando assim, predições acuradas de forma computacionalmente mais eficiente. O objetivo desta etapa é o de desenvolver potenciais interatômicos (campos de força) para descrever as forças nas moléculas de água melhores do que os atualmente disponíveis na literatura. |

|

Estudo do acoplamento entre sawteeth and tearing modes no tokamak TCABR (ntm) Universidade de São Paulo Departamento de Física Aplicada Coordenador: Gustavo Paganini Canal Áreas do conhecimento: Física Início da vigência: 17-11-2017 The potential of nuclear fusion to provide a practically inexhaustible source of clean and renewable energy has motivated scientists to work toward developing nuclear fusion power plants. In this work, an outstanding issue encountered on the road toward the development of nuclear fusion will be addressed, namely the seeding of neoclassical tearing modes (NTMs) by sawteeth (ST) in tokamak plasmas. Although ST and NTMs have been intensively investigated over the last decades, a validated quantitative theory of the triggering of NTMs by ST remains to be developed. Many tokamaks observed that ST of sufficient duration may trigger NTMs that can lead to plasma performance degradation and/or disruptions, depending on the plasma conditions. From constraints imposed on the plasma performance, the onset of NTMs poses a threat to the main goal of ITER, which is a prototype intended to demonstrate sustained burning plasma operation with a fusion power gain factor Q = 10. This work seeks to investigate the mechanisms of NTM seeding by ST using the TCABR tokamak, located at the Laboratório de Física de Plasmas - LFP, Instituto de Física, Universidade de São Paulo. Experiments will be carried out in order to investigate the non-linear dynamics involved in the NTM seeding by the modes generated during the ST crash. To provide a better understanding of the dynamics behind mode coupling, the experimental measurements will be interpreted by numerical modeling using M3D-C1, which is a state-of-the-art code for plasma modeling that has recently been developed at the Princeton Plasma Physics Laboratory, Princeton, USA. Understanding the different possible mechanisms behind NTM seeding is of utmost importance for the development of controlled thermonuclear fusion as an economically viable energy source. The knowledge acquired during this work could lead to the development of a model in which the relative contribution from distinct seeding mechanisms and their scalings are known. This model could ultimately then be used predictively to indicate zones of safer operation at higher plasma pressures in existing tokamaks worldwide and in the design of future devices. |

|

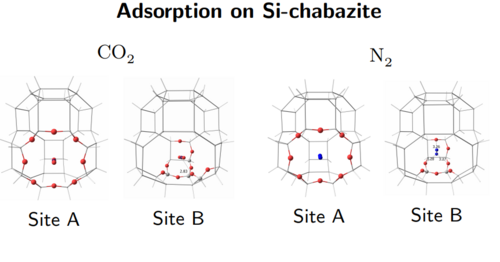

Estudo teórico-computacional de zeólitas com aplicações em catálise e adsorção (chaersd2) Universidade Federal do Rio de Janeiro Departamento de Físico-Química Coordenador: Marco Antonio Chaer do Nascimento Áreas do conhecimento: Ciência dos materiais; Química Início da vigência: 20-12-2019 Trata-se da renovação de um projeto já apoiado pelo LNCC que é, na verdade, um sub-projeto do Núcleo de Excelência em Funcionalização de Hidrocarbonetos, que visa desenvolver métodos para a produção de compostos químicos, de alto valor, a partir de matéria prima abundante no país, através de reações de funcionalização de hidrocarbonetos, usando zeólitas. Em termos de aplicações práticas, este sub-projeto pretende ampliar a compreensão do mecanismo das reações catalisadas por zeólitas, e de sua ação adsorvente em processos industriais de grande importância econômica. A partir desta compreensão, será possível contribuir para o desenvolvimento de: (a) novos catalisadores para importantes processos industriais, sobretudo nas indústrias de refino de petróleo e petroquímica, capazes de promover reduções de custos e melhor aproveitamento do petróleo e do gas natural; (b) novos adsorventes para separações gasosas de interesse da indústria de petróleo e do gas natural, e da indústria de produção de gases especiais; (c) novos adsorventes para captura de dióxido de carbono emitido por grande fontes estacionárias, com efeitos positivos na redução do aquecimento global. |

|

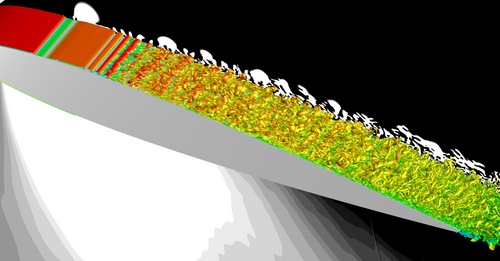

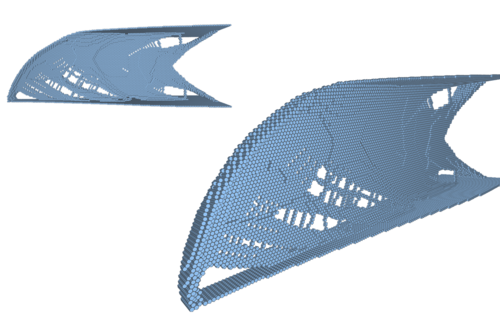

High-Fidelity Numerical Simulations of Wall-Bounded Turbulent Flows (hfwbtf) Instituto de Aeronáutica e Espaço Divisão de Aerodinâmica Coordenador: João Luiz Filgueiras de Azevedo Áreas do conhecimento: Engenharias Início da vigência: 24-07-2018 A presente proposta foi criada a partir de um projeto de colaboração internacional entre o Instituto de Aeronáutica e Espaço (IAE), Universidade de Campinas (UNICAMP), Instituto Tecnológico de Aeronáutica (ITA) e École Nationale Supérieure d'Arts et Métiers (ENSAM-ParisTECH), da França. A mesma visa diversas aplicações científicas e tecnológicas, como por exemplo, na área de energia eólica, engenharias mecânica e aeronáutica. O foco principal é o estudo de escoamentos compressíveis na presença de paredes sólidas, o que é típico em aplicações de engenharia e muito desafiador. As configurações investigadas incluem aerofólios, canais e trens de pouso. Existe o interesse em análise da física da turbulência, um dos "Millennium Prize Problems" de matemática, além da geração de ruído, tema atual devido às recentes restrições de emissão de ruído para aviação civil. Simulações de grandes escaladas, LES, com alta resolução e formulações híbridas RANS-LES, são as abordagens escolhidas para serem aplicadas na presente proposta. Estas abordagens serão aplicadas para os escoamentos de interesse com o objetivo de capturar mecanismos aerodinâmicos transientes e os correspondentes efeitos acústicos. Para o caso de estudo de escoamento sobre aerofólios e escoamentos em canais, esquemas numéricos de diferenças finitas de alta ordem e alta resolução serão empregados usando LES para a solução de estruturas turbulentas mais energéticas com o mínimo possível de adição numérica de fenômenos dissipativos e dispersivos sobre estruturas turbulentas. Com intuito de obter soluções acuradas, malhas estruturadas serão desenvolvidas para a resolução de camadas limites sobre as configurações de aerofólio e canais. Para o estudo de trens de pouso, a abordagem híbrida pode ser empregada para o cálculo dos escoamentos turbulentos. Este tipo de abordagem é capaz de capturar as estruturas mais energéticas do escoamento que são responsáveis pela geração de ruído. Esta formulação implica modelamento de turbulência sobre regiões onde as escalas de alta frequência estão presentes ou em regiões onde existe a presença de malhas de menor resolução. É importante lembrar que este tipo de abordagem é menos custosa quando comparada à formulação LES com resolução de parede. Diferentemente das configurações de aerofólio, trens de pouso apresentam diversos detalhes geométricos adicionais com diferentes escalas de comprimento. Esses detalhes não podem ser devidamente resolvidos usando malhas estruturadas e métodos de alta-ordem de precisão. Neste sentido, técnicas de discretização do tipo volumes finitos serão empregadas juntamente com malhas não estruturadas híbridas. |

|

Implementação e validação de um modelo de escoamento bifásico líquido-gás com diferentes escalas de interface (mflow) Universidade Federal de Santa Catarina Departamento de Engenharia Mecânica Coordenador: Emilio Ernesto Paladino Áreas do conhecimento: Engenharias Início da vigência: 07-06-2019

Escoamentos bifásicos líquido-gás possuem papel importante em processos naturais e industriais, principalmente na indústria química e petrolífera. Escoamentos desse tipo abrangem inúmeras áreas e processos de engenharia, como por exemplo o projeto de equipamentos para transporte de fluidos, produção de petróleo e gás, sistemas de arrefecimento, etc. Em geral, escoamentos bifásicos líquido-gás podem apresentar diferentes padrões, afetando de modo complexo a sua hidrodinâmica e também a transferência de calor e de massa.\nDevido à complexidade dos diferentes padrões de escoamento presentes em situações reais, um grande esforço é dedicado a melhor compreensão de escoamentos bifásicos líquido-gás. Nos últimos anos, a fluidodinâmica computacional (Computational Fluid Dynamics, CFD em inglês) tornou-se uma ferramenta importante, permitindo uma análise detalhada dos mecanismos físicos que regem o fenômeno. Desse modo, o trabalho descrito aqui possui caráter fundamental e pode encontrar aplicações em sistemas multifásicos, como sistemas de medição, processos envolvendo transferência de calor e massa, sistemas de alta eficiência energética e demais.\n |

|

Inteligência Computacional em Processamento de Alto Desempenho (hubdigital_coppe) Universidade Federal do Rio de Janeiro Programa de Engenharia Civil Coordenador: Alexandre Gonçalves Evsukoff Áreas do conhecimento: Ciência da computação; Engenharias; Geociências; Meteorologia Início da vigência: 03-07-2019

Nos últimos anos, o aumento do volume de dados observados ou produzidos por simulação numérica e a capacidade de processamento dos computadores permitiram o desenvolvimento de novos algoritmos e modelos de redes neurais cada vez mais complexas, com milhares de unidades de processamento e milhões de parâmetros. Esses modelos são chamados de redes neurais profundas e são ajustados por algoritmos de aprendizado profundo (deep learning). Resultados recentes em problemas complexos como visão computacional e processamento de linguagem natural mostram que redes neurais profundas são capazes de realizar tarefas complexas de sistemas de inteligência computacional. Em problemas da ciência da natureza, modelos de redes neurais realizam a modelagem de relações espaciais de longo alcance em várias escalas de tempo (https://www.nature.com/articles/s41586-019-0912-1) |

|

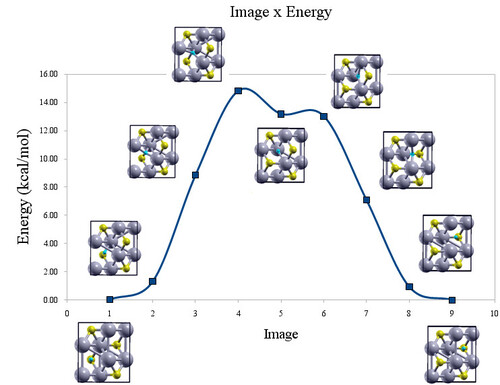

Mecanismo de oxidação de carbetos de metais de transição (moc) Universidade Federal do Rio de Janeiro Departamento de Físico-Química Coordenador: Alexandre Braga da Rocha Áreas do conhecimento: Ciência da computação; Engenharias; Química Início da vigência: 20-06-2018 Dentre as diversas aplicações de carbetos de metais de transição, destaca-se seu uso como catalisador em diversos tipos de reações, podendo substituir catalisadores mais caros, baseados em metais do grupo da platina. Os mais promissores carbetos são os de molibdênio, tungstênio, nióbio e vanádio. Esses já apresentam aplicações, não somente em catálise heterogênea como também na composição de baterias e capacitores. O controle da oxidação é um problema recorrente na química de carbetos, uma vez que a eficiência e seletividade destes como catalisadores depende do grau de oxidação da superfície. Na síntese desses materiais é importante o controle da quantidade de oxigênio na superfície exposta, onde a reação irá ocorrer. além disso, para trasnporte ou caracterização destes materiais, é costume estabelecer uma camada passivadora de óxido. No entanto, a eficiência desse processo é questionável devido à possibilidade de difusão de oxigênio nesta camada, destruindo ou modificando o material subjacente, que quer se proteger. Mecanismos de oxidação de superfícies envolvem não apenas a etapa de aumento da cobertura e de quebra da ligação O-O como também o estudo da difusão de oxigênio. Dessa foprma, cada uma dessas etapas deve ser investigada para um melhor controle do processo de oxidação desses materiais. Apesar da importância da oxidação na química de carbetos, existem poucos estudos na literatura sobre os mecanismos de oxidação. O estudo teórico das etapas de adsorção e difusão de oxigênio ajudam a elucidar este mecanismo em nível molecular. A análise das etapas do mecanismop de oxidação em nível teórico é complementar aos estudos feitos em laboratório e permite um entendimento do processo de oxidação, em nível molecular, que a maioria dos experimentos não fornece. Os resultados obtidos por cálculos ab initio podem auxiliar os experimentalistas no desenvolvimento de estratégias de controle na síntese e na conservação dos carbetos. Assim, carbetos podem ser projetados com propriedades otimizadas para umas aplicação desejada. Dessa forma, o objetivo do projeto é estudar, utilizando a teoria do funcional da densidade, os processos de adsorção e difusão de oxigênio nos referidos carbetos. O projeto visa a obtenção da energia de ativação para o processo de difusão de oxigênio, o coeficiente de difusão e o grau de cobertura de oxigênio. |

|

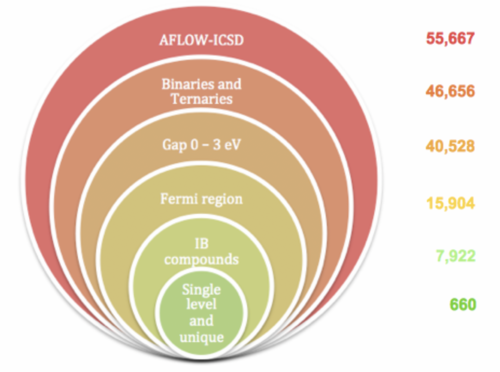

Métodos Quânticos e Empiricos Aplicados no Estudo e Desenvolvimento de Materiais para Aplicações em Novas Energias (qtnano2) Universidade de São Paulo Instituto de Química de São Carlos Coordenador: Juarez Lopes Ferreira da Silva Áreas do conhecimento: Física; Química Início da vigência: 09-04-2019

Estudos têm indicado que a contribuição da energia solar obtida através da conversão de fótons em elétrons via dispositivos semicondutores deve aumentar sua contribuição na matriz energética mundial de 1% para 30%, o que deve contribuir significativamente para para a redução da emissão de CO2 e, consequentemente, desaceleração do aquecimento global. O Brasil, como signatário das principais convenções internacionais sobre meio ambiente, deve adotar medidas de incentivo ao maior aproveitamento da energia solar, o que, entretanto, requer avanços científicos consideráveis, principalmente, no desenvolvimento de materiais para a construção de dispositivos de conversão energética com alta eficiência e baixo custo. Neste projeto, portanto, concentraremos nossos esforços em três classes promissoras de materiais, especificamente, calcogenetos, perovskitas, e materiais orgânicos, os quais foram selecionados devido às seguintes razões: |

|

Modelação e estatísticas de extremos de ventos e ondas no Oceano Atlântico (exwav) Universidade de São Paulo Centro de Engenharia e Tecnologia Naval e Oceânica Coordenador: Ricardo Martins Campos Áreas do conhecimento: Engenharias; Meteorologia; Probabilidade e estatística Início da vigência: 29-03-2019

A reconstituição da atmosfera e da agitação marítima utilizando modelagem numérica computacional (hindcasts) é extremamente importante para cálculos de parâmetros meteo-oceanográficos utilizados pela indústria offshore bem como para a segurança costeira. Apesar do aumento recente da cobertura e duração das medições com boias e satélites, os hindcasts ainda são a principal fonte de dados para o cálculo de valores extremos de longo período. Isso se deve à grande cobertura espacial e temporal, com informações contínuas e sem spikes. A importância e dependência dos hindcasts se tornam ainda maiores em regiões com poucas medições, como no Atlântico Sul. Dois pontos são importantes na construção dos hindcasts: 1) O sistema de assimilação de dados dos modelos atmosféricos aproximam as simulações para as condições reais presentes através das medições. Portanto, em regiões com baixa densidade de observações, os hindcasts têm erros muito maiores. 2) Os modelos numéricos são calibrados alterando os parâmetros internos a fim de minimizar certas métricas de erros, considerando todo espaço amostral (eventos calmos e extremos) e toda a cobertura espacial (geralmente o globo todo). Portanto, o impacto da qualidade dos eventos extremos no erro médio integrado é muito pequeno – justamente por serem raros e possuírem cobertura espacial limitada. Por esses motivos, os hindcasts costumam subestimar consideravelmente os eventos extremos e superestimar condições calmas. Isso gera dois problemas graves quando usados para ajustar distribuições de extremos: 1) A subestimação dos extremos é amplificada ao se extrapolar a função quantil, para o cálculo dos valores de retorno; 2) A subestimação dos extremos e superestimação das condições calmas têm um impacto nos momentos probabilísticos e nas distribuições, que são a base para os métodos tradicionais de cálculo de valores extremos. |

|

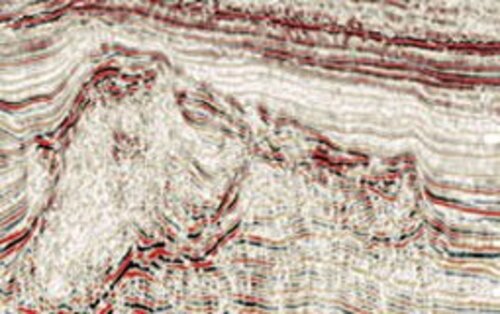

Modelagem Computacional de Reservatórios de Petróleo com Complexidade Geológica (simulreserv) Laboratório Nacional de Computação Científica Coordenação de Modelagem Computacional Coordenador: Marcio Rentes Borges Áreas do conhecimento: Ciências humanas; Engenharias; Matemática Início da vigência: 22-03-2018 Os reservatórios presentes na chamada camada pré-sal, localizados na costa brasileira, entre os estados do Espírito Santo e Santa Catarina, em uma faixa que se estende por cerca de 800km, representam um grande potencial petrolífero para o país. Tais reservatórios estão localizados a grandes profundidades, sob uma espessa camada de rochas salinas (com propriedades viscoelásticas), o que torna sua exploração um desafio científico e tecnológico. É neste contexto que, dentre os objetivos estratégicos previstos no Plano Diretor do LNCC, está a linha de pesquisa aplicada na área de Petróleo, Água e Gás que tem por objetivo consolidar a atuação do LNCC como um centro de referência nas áreas de modelagem numérica de processos de prospecção de óleo, gás natural e águas subterrâneas, bem como transporte de poluentes em solos e armazenamento de CO2 em reservatórios de petróleo e aquíferos, desenvolvendo pesquisa aplicada e formação qualificada de recursos humanos, com potencial de iteração com o setor produtivo. Em virtude disso, o LNCC faz parte do Programa de Recursos Humanos da Agência Nacional do Petróleo (PRH - 50 - Modelagem Computacional Hidro-Geomecânica de Reservatórios não Convencionais) que tem como objetivos: i) formar recursos humanos altamente qualificados para atender a demanda do setor de Petróleo e Gás; ii) ampliar as atividades de pesquisa do LNCC em áreas estratégias; iii)desenvolver novas formulações e metodologias computacionais orientadas para simulação de processos avançados de recuperação de petróleo e gás em reservatórios não convencionais; iv) atender à crescente demanda de candidatos aos programas de Mestrado e Doutorado em Modelagem Computacional do LNCC. Atualmente, a equipe de Simulação de Reservatórios do LNCC (da qual o proponente faz parte), no âmbito do projeto “Modelagem e Simulação Numérica de Escoamentos em Reservatórios Heterogêneos com Acoplamento Geomecânico” da rede SIGER (patrocinado pela PETROBRAS), vem desenvolvendo diversos códigos computacionais capazes de simular o escoamento de fluidos em reservatórios de petróleo heterogêneos, caracterizados pelo acoplamento hidro-geomecânico, fazendo uso de métodos numéricos localmente conservativos. Tais reservatórios, geralmente, são constituídos de rochas carbonáticas que podem apresentar estruturas geológicas complexas, tais como cavernas, vugs, juntas, falhas e veios, com uma vasta gama de heterogeneidades físicas e químicas que influenciam fortemente a produção de hidrocarbonetos. Cabe ressaltar que, a simulação numérica de problemas reais, postos em escalas de campo (da ordem de quilômetros), e discretizados na escala de laboratório (da ordem de centímetros e na qual as equações e as propriedades das rochas são conhecidas), dá origem a problemas computacionais de grande porte que exigem computação de alto-desempenho para que os mesmos sejam factíveis em tempo razoável. Então, o objetivo central do presente projeto é utilizar o potencial do supercomputador Santos Dumont para resolver problemas cada vez mais complexos e detalhados na área de simulação de reservatórios de petróleo, ajudando a indústria a tomar decisões acertadas com base nos conhecimentos gerados. |

|

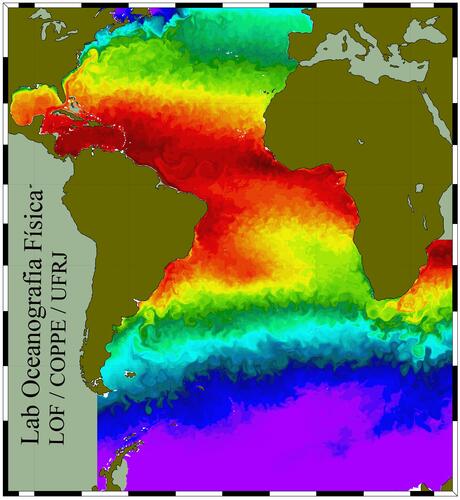

Modelagem da Circulação no Oceano Atlântico Sul (modoceano2) Universidade Federal do Rio de Janeiro Programa de Engenharia Oceânica Coordenador: Afonso de Moraes Paiva Áreas do conhecimento: Engenharias; Geociências Início da vigência: 12-08-2019

O Projeto MODOCEANO é um projeto institucional do nosso laboratório na UFRJ, que visa o desenvolvimento de modelagem computacional, em alta resolução, da circulação oceânica em diferentes escalas espaciais e temporais no Atlântico Sul. São investigados aspectos relacionados: |

|